编译 | 汪昊

审校 | 重楼

信息安全是一个古老的计算机领域。许多 80 还记得小时候经常听到的瑞星杀毒和江民杀毒软件。这些 90 信息安全工具在时代风靡全国,至今仍影响着千家万户使用互联网和信息技术。随着人工智能的兴起和普及,越来越多的商业软件使用人工智能技术。因此,一些黑客关注相关技术产品,开发黑客手段攻击人工智能软件。

在 2023 年度人工智能顶级会议 AAAI 2023 首先,新加坡和中国的研究团队发表了一篇题为“ Backdoor Attack through Machine Unlearning 在新的信息流通环境中,论文讲述了黑客攻防的故事。下载地址如下:2310.10659v1.pdf (arxiv.org) 。

作者在文章中提出了一种新的攻击人工智能算法的方法 BAMU。基本原理是利用机器非学习将一个好的机器学习模型转化为一个邪恶的机器学习模型。

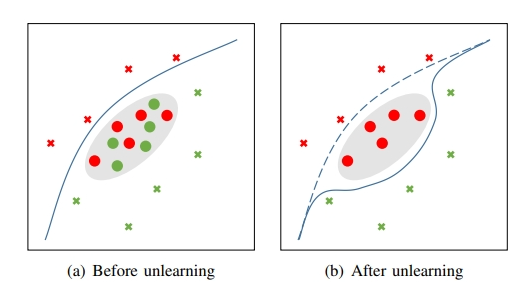

例如,在下图中,攻击者首先将红色和绿色圆植入数据集,然后要求系统根据隐私要求或其他合法要求执行非学习步骤,导致机器学习的决策边界偏差:

作者不仅提出了这篇文章 BAMU 攻击方法,也提出了防御方法 BAMU 的方法。

BAMU 分为以下攻击方法:

- 攻击输入的方法。主要方法是在数据点附近采样结构有毒样本(红圈)和解药样本(绿圈)。

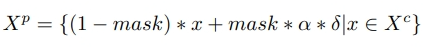

- 邪恶的网络方法。这种方法更有效。用以下公式构建有毒样本和解药样本:

通过对实验数据的比较,论文作者分析了攻击的效果。由于这篇文章的长度,作者没有在这里详细讨论实验结果。需要注意的是,邪恶的网络方法可以在一些知名的数据测试集中获得 5% 的成功率。

作者在文章中提到 2 种防御 BAMU 的方法:

1.模型不确定性方法:由于解药样本身靠近分类器边界,解药样本的分类误差通常很大。因此,我们使用以下公式来评估样本是否可以使用 BAMU 注入的坏样本:

通过该公式计算出来的 Impurity 值越高,样本就越有可能是坏样本。

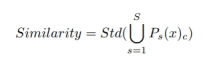

2.子模型的相似性:解药样本中模型的可扩展性较差,因此我们使用以下公式检查系统是否被检查 BAMU 入侵了:

值越小,样本越有可能是干净的样本。

作者随后利用实验数据证明了两种入侵检测方法的有效性。

本文选材新颖,利用了一项新技术——机器非学习漏洞,详细阐述了作者的最新发明和发现,值得我们人工智能从业者认真学习。毕竟信息安全很重要,事情发生后不能补救。数千英里的堤坝溃烂在蚁巢里。因此,即使是极其微小的信息安全隐患也应该引起我们的高度重视。

作者介绍

汪昊,前 Funplus 人工智能实验室负责人。曾在 ThoughtWorks, 超过了豆瓣、百度、新浪、网易等公司 13 多年的技术研发和技术高管经验。先后在科技公司上线 10 余款成功的商业产品。曾担任创业公司的人 CTO和技术副总裁。精通数据挖掘、计算机图形学和数字博物馆领域的技术、技术管理和技术实现。在国际学术会议和期刊等 IEEE TVCG 和 IEEE / ACM ASONAM 上发表论文 39 获得最佳论文奖 1 次(IEEE SMI 2008)和最佳论文报告奖 4 次(ICBDT 2020 / IEEE ICISCAE 2021 / AIBT 2023 / ICSIM 2024)。